プロンプトインジェクションとは、生成AIを意図的に誤作動を起こさせるような指令入力を与え、提供側が出力を禁止している情報(開発に関する情報、犯罪に使われうる情報等)を生成させる攻撃です。これにより、攻撃者はシステムの制御を奪ったり、機密情報を盗んだり、不正な操作を行ったりすることができます。

生成AIに対する攻撃においては、英国の著名なプログラマであるSimon Willison氏が2022年9月に、後段のプロンプトから前段のプロンプトの挙動へ介入できてしまうことを実証しました。ただし、生成AIサービス提供者側の防御施策も成熟してきており、少し前に実証された攻撃方法が今も利用可能であるとは限りません。実は防御ノウハウこそが生成AIサービスにおける重要なポイントであるという見立てもできます。

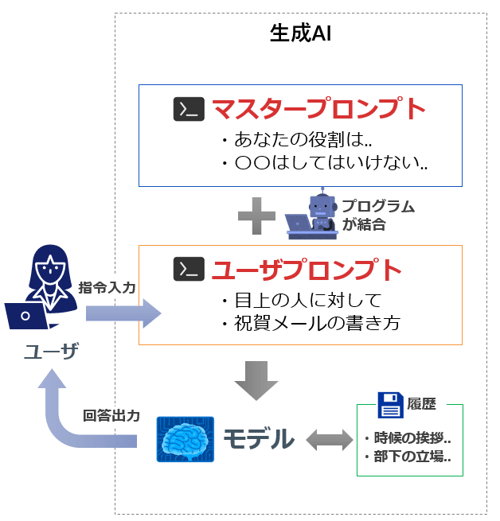

生成AIのプロンプトの仕組み

参考までに、生成AIサービスにおけるプロンプトの仕組みを簡単に紹介します。本体にあたる「モデル」の入出力インターフェースは自然言語であり、入力にあたる「プロンプト(指令)」は、以下2つを文字列結合したものを、モデルへの入力文(プロンプト)としています。生成AIサービスが設定した「マスタープロンプト」と、ユーザが入力する「ユーザプロンプト」があります。一連の会話は履歴に記録され、ユーザプロンプトやモデルの応答をフィードバックとして次の出力に影響を与えることがあります。