昨今、ChatGPT(Open AI)やGemini (Google)に代表されるようなテキスト生成AIを始めとするAIが注目を集めており、AIの利活用の検討が進んでいる、もしくは今後検討したい企業も多いのではないでしょうか。

AIの利活用は、ビッグデータの分析による消費者へトレンドを押さえたサービス提供や、チャットボットを利用したきめ細やかな質問対応等、これまで以上の価値提供に寄与できる可能性を秘めている一方、リスクも存在します。AIを利活用する際のリスクのポイントは大きく、AIモデルに対する攻撃等の外部攻撃リスク、法規制に違反するリスク、誤判断・検知漏れ等の品質リスクがあります。

本ブログでは、3点目のAIの品質リスク、およびそのリスク対策にフォーカスし、『AIの品質』を維持するための3つのステップを紹介します。

<関連記事>

AIの品質が重要な理由とは

AIの品質リスクの例としては、外部の環境変化に伴うデータ傾向の変化等により品質が刻々と変化すること、AIの判断や生成物には虚偽の内容が含まれる可能性があること、等が挙げられます。このようなリスクが存在する中、AIの品質が確保できない場合、どのような問題が発生するでしょうか。

例えば、企業が消費者向けにテキスト生成AIを用いたチャットボットを提供した際の品質上の問題として、差別的・攻撃的な出力をしてしまう、正答率が悪くオペレーターへの問い合わせ数が減らない、等が考えられます。結果として、チャットボットサービスの停止、企業へのネガティブなイメージが拡散されることによるブランド毀損、等の問題が発生する可能性があります。

以下に、ハルシネーションと呼ばれる事実に基づかない情報を生成する事象や、データドリフトと呼ばれる、モデル訓練時のデータの統計分布と本番環境でのデータの統計分布に差分が生じた際に発生する事象から、実際の問題事例を紹介します。

ハルシネーションの事例 [i]

2023年5月下旬、米東部ニューヨーク州の弁護士が審理中の民事訴訟で用いられた資料において引用された判例が見つからなかったため、ニューヨーク州連邦裁判所の裁判官が確認したところ、弁護士がChatGPTを使っていたことが発覚し、6件の実在しない判例を引用していました。その後の謝罪や改善措置が評価され、厳しい制裁を科すことは適当ではなく、5000ドルの罰金に留めることになりました。

データドリフトの事例 [ii]

米国の某大手不動産検索サイトの住宅価格をAIが査定し購入・リノベーションして再販するサービスを手掛けていました。当該サービスはコロナ禍前の学習データで価格予測を行っていましたが、コロナ禍で起こった住宅需要の変化を捉えきれず、多くの住宅を実際より高額で購入し続けました。結果として推定約3億8000万ドルの損失を被ることになりました。

このようにAIの品質が確保できていない、またAIの品質リスクを理解できていない場合、多額の損失に発展する可能性があります。

次に、このようなAIの品質に関する問題が発生する原因について解説します。

AIの品質に関する問題が発生する原因

AIの品質に関する問題が発生する原因として、AIシステムは学習データの品質や特性によって振る舞いが大きく左右されることが挙げられます。

例えば、学習データに必要な情報が含まれなかったりバイアスが存在することでハルシネーションが発生してしまう、あるいは学習時と本番運用時のデータの統計的分布が変化したりすることでデータドリフトが発生し誤判断をしてしまう、等の品質上の問題が顕在化することが考えられます。

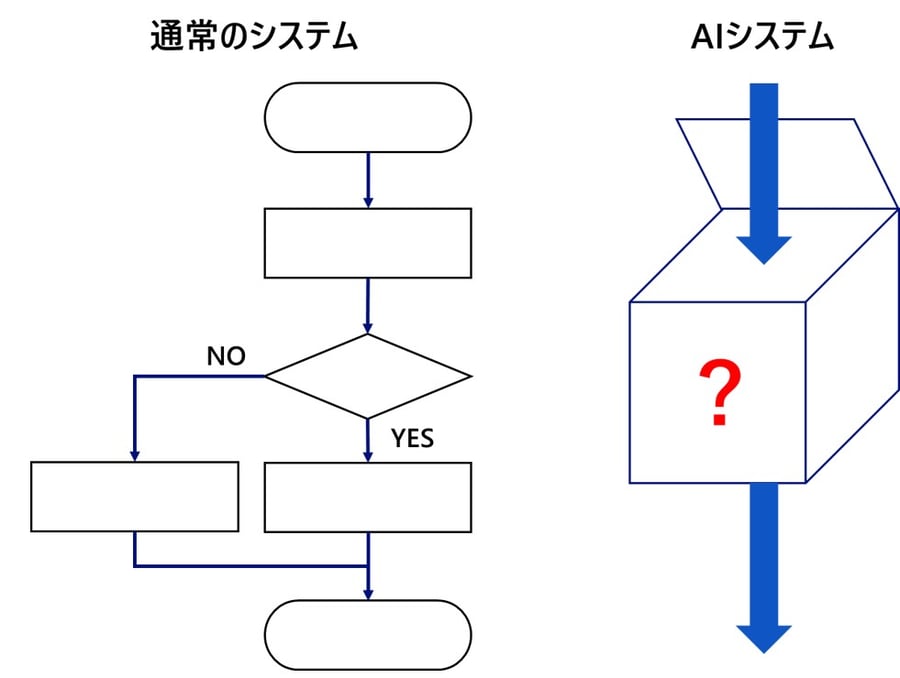

また、品質上の問題が顕在化した際の修正も容易ではありません。これは、通常のシステムと異なりAIシステムはロジックがブラックボックス化されているためです。

通常のシステムの場合、要求仕様に基づき人間でロジックを検討し、どのような工程でどのような処理を行うかコーディングします。したがって、通常のシステムの場合は、その動作は人間が決めたものであり、システムがなぜそのような動作をするのかを人間が理解することができます(下左図)。そのため、品質上の問題が顕在化された際、原因の特定や修正が容易です。

一方、AIシステムのロジックの場合、AI自身が大量のデータから自動で学習します。現在多くのAIで用いられているニューラルネットワークでは、用いられているパラメータが多いもので数千億とあり、どのような過程を経て出力がなされたのか人間が理解することは困難です(下右図)。そのため、品質上の問題が顕在化された際、原因の特定や修正は容易ではありません。

次に、このような確保することが難しいAIの品質を維持するためのポイントを解説します。

AIの品質を維持するための3つのステップ

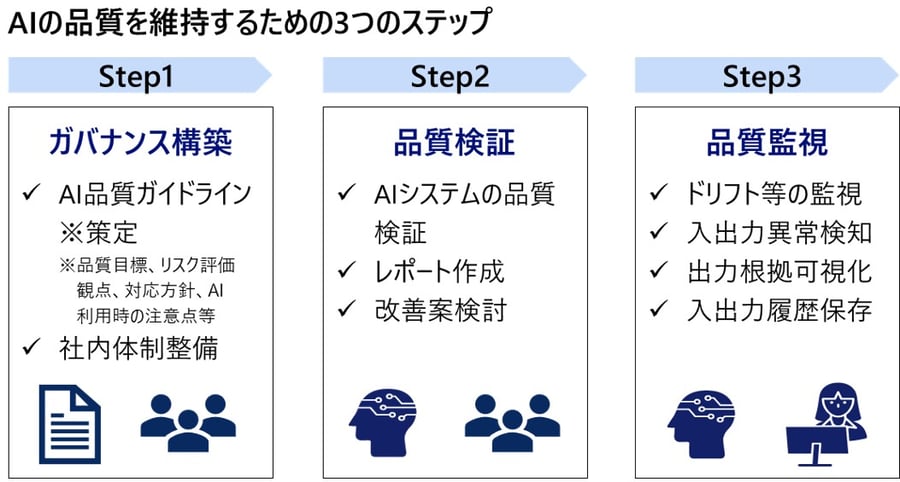

これまで述べてきたように、「品質確保が容易でないAI」の品質を維持するためのポイントを3つのステップに整理して解説します。

概要は下図に示すように、まず企業のユースケースに沿ったAI品質ガイドライン策定などのガバナンス構築を行います(Step1)。次にAIシステム開発時の品質検証を行い(Step2)、開発時点で品質が確保されたAIシステムをデプロイした後、品質監視を行います(Step3)。

次に、各ステップで実施すべき内容を深堀し、解説します。

ステップ1:AI品質に関するガバナンス構築

AIの品質を維持するためには、まず組織としてのルール(ポリシー・ガイドライン)の規定が必要になります。例えば、AI品質のリスク評価観点や対応方針、AI利用時の注意点(AIの判断や生成物には虚偽の内容が含まれる可能性がある、等)を企業のユースケースに沿って策定する必要があります。

また、AIシステムを導入するにあたり、各ステークホルダー(経営企画部、情報セキュリティ部、AIシステム利用部門、法務・コンプライアンス部門等)で役割を整理し、役割に応じた業務を実施する体制を整備する必要があります。

ステップ2:開発時の品質検証

AIシステムのリリース時に品質を確保するために品質検証を行うことが必要です。例えばテキスト生成AIの場合、様々なプロンプトを入力し、出力の正答率や有害性などの割合を測定し、目標とする品質に到達しているか検証する必要があります。

また、リリース時に品質を担保することが必要ですが、AIシステムは学習と検証を繰り返す必要があるため、当然モデルの品質検証もその都度実施する必要があります。

さらに、開発時にはモデルの品質検証だけでなく、学習用データセットや評価用データセットの品質検証も必要です。学習用データセットに不正データが含まれる場合には学習結果の汚染のリスク等があり、評価用データセットにバイアスがある場合は適切な品質検証が実施できません。また、正しく品質検証を行うために、学習用データセットと評価用データセットは互いに独立する必要があることも念頭に置く必要があります。

なお、EUにおいてAIサービスを提供した場合などに適用される包括的な規制であるEU AI Actでは、人事採用、重要インフラ、生体識別等、「ハイリスクAI」に該当するAIシステムの場合は品質適合性検証が必要となります[iii]。

ステップ3:運用時の品質監視

開発時に品質が担保できていたとしても、AIシステムの品質は時々刻々と変化するため、品質が劣化するリスクがあります。したがって、AIシステムの開発期間中や運用開始時だけでなく、運用が始まってからこそ品質が重要になります。

また、目標の品質を維持できていたとしても、その精度は100%とはならないため、思いもよらない結果が出力されたり、ユーザからの異常な入力により誤動作が発生したりするリスクもあります。

このようなリスクに対して、例えば需要予測AIの場合、データドリフト、入出力の外れ値等を監視し、異常な入出力を検知・遮断したり、有事の際に適切な相手に適切なタイミングで提示できるよう入出力結果を継続的に記録したりしておく必要があります。

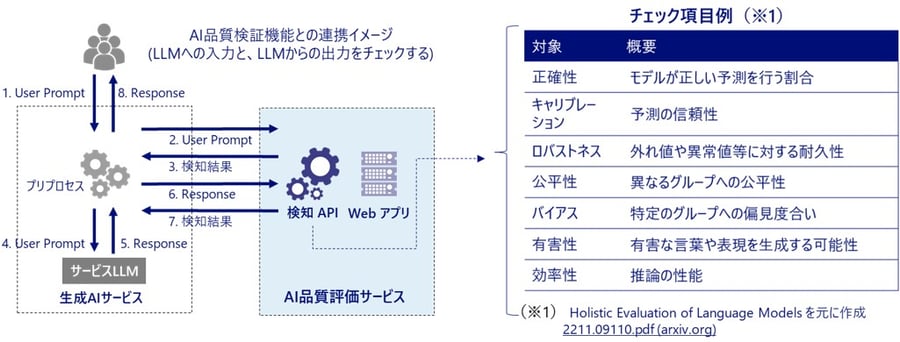

しかし、繰り返し実施する必要のある開発時の品質検証や、多くの入出力が行われる運用の品質監視を人手で行うことは多くの手間、時間が必要で困難です。そこで、ツールを用いた品質検証や監視を行うことも視野に入れ、AIシステムの品質確保を行うことが必要です。

下図は大規模言語モデル(LLM)と品質検証ツールの連携イメージです。LLMへの入出力に対して正確性や有害性などを自動で検証することが可能です。このようなツールを用いることで、人手での実施が困難な品質検証や監視を自動で実現可能であるため、非常に有用であると考えられます。

大規模言語モデル(LLM)と品質検証ツールの連携イメージ

おわりに

AIの利活用は企業にとってこれまで以上の価値提供に寄与できる可能性を秘めています。一方で、AIには様々なリスクも存在する中、本ブログではAI品質リスク対策にフォーカスして説明しました。

AIを利活用する上で、品質に係るガバナンス構築(ルール作り)から始まり、品証検証・品質監視といった技術的対策も必要となりますが、特に技術的対策は人手で実施することは困難です。

本ブログでは、AIの品質に関するリスク、および対策の3つのステップを説明しましたが、どのようにAI開発時の品質検証を行うのか、運用時の品質監視を行うのかは企業のユースケースによって異なります。AIの品質に課題をお持ちの際は当社のAI品質・適合性検証サービスをご活用ください。

<関連サービス>

[i] REUTERS New York lawyers sanctioned for using fake ChatGPT cases in legal brief https://www.reuters.com/legal/new-york-lawyers-sanctioned-using-fake-chatgpt-cases-legal-brief-2023-06-22/

[ii] 日経ビジネス なぜAIは嘘をつく Googleは株価急落、Zillowは巨額損失 https://business.nikkei.com/atcl/gen/19/00548/042100002/?P=2

[iii] 総務省 EUのAI法規制法案の概要 https://www.soumu.go.jp/main_content/000826707.pdf