「信頼できるAI」を実現するために何から始めたらいいのか?

AI の「信頼性」という観点において、どのような課題があり、その課題にどのように立ち向かっていくかを特集テーマとして、複数回に分けてその基本を解説しています。前回の記事でも触れた通り、Trustworthy AI(信頼できる AI)は、今後のAIの活用を進めていくうえで、AI が備えなければならない性質となります。

また、本特集の初回の記事では、「信頼できる AI」に必要不可欠な4つの性質として、「Robustness(頑健性)」、「Explainability(説明可能性)」、「Fairness(公平性)」、「Privacy(プライバシー)」の概要を解説しましたが、これら4つの性質は、AI の「モデルそのものが満たすべき性質」という側面が強く、より広い視野を持つと考慮すべき点はさらに増えます。

AI サービス提供者からすると、如何にして「信頼できる AI」 を実現するかについて、「何を拠り所として取りかかればよいのか分からない」というのが実態かと思います。

幸いにも、世界各国の政府機関や政府間組織、学術機関、公益団体、民間組織が「信頼できる AI 」を実現するための公的文書の整備、公開をはじめていますので、これらを最初の拠り所とするというのは有用なアプローチと考えます。

そこで、本記事では、読者が「信頼できる AI」を実現するための一助となるべく、これらの文書が、「信頼できる AI」の観点で、どのような点に注目し、どうあるべきかについて言及しているのかについて概要をわかりやすく説明します。

「信頼できるAI」に関する公的文書の整備の進展

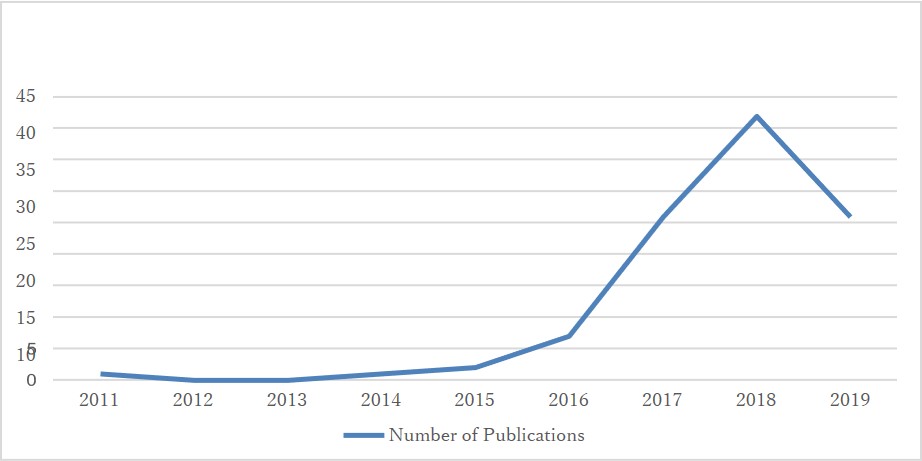

人工知能(AI)の研究は1950年代に始まったといわれていますが、「信頼できるAI」とは何か?(「どこまでAIに任せられるのか?」、「何に使うべきか?」、「どう使いこなすのか?」等)といった観点での議論が活発化してきたのは、比較的近年です。AIを活用した画像認識や音声認識、自然言語処理等、様々な技術の実用化が進み、ビジネスや社会の様々な難問を解決するための技術としてAIへの期待が高まっていることが背景と考えられます。

「信頼できるAI」に関する公的文書の整備公開が進み始めたのは、2010年代半ば以降で、現在では、冒頭でも述べたとおり、世界各国の政府機関や政府間組織、学術機関、公益団体、民間組織が公的文書を整備、公開しています。(図1参照)

図1「信頼できるAI」の性質を定めた公的文書の発行数(全世界)

※図のタイトル名は本記事の用語に合わせて変更

出所)AI Ethics Guidelines: European and Global Perspectives 15 June 2020

AD HOC COMMITTEE ON ARTIFICIAL INTELLIGENCE (CAHAI) Provisional report by Marcello Ienca and Effy Vayena Chair of Bioethics, Health Ethics and Policy Lab, Department of Health Sciences and Technology, ETH Zurich.

https://rm.coe.int/cahai-2020-07-fin-en-report-ienca-vayena/16809eccac

これらの公的文書には、法的拘束力や強制力はありません※1が、AI を利用したシステム開発やサービス提供を行う企業の意思決定に実際的な影響を与える役割が期待されています。

- ※1 ソフトロー文書とハードロー文書

対象主体の自主性に任せることを前提とした公的文書をソフトロー文書、法的拘束力や強制力を持たせた公的文書をハードロー文書と呼ぶことがあります。本記事でとりあげる公的文書はソフトロー文書です。

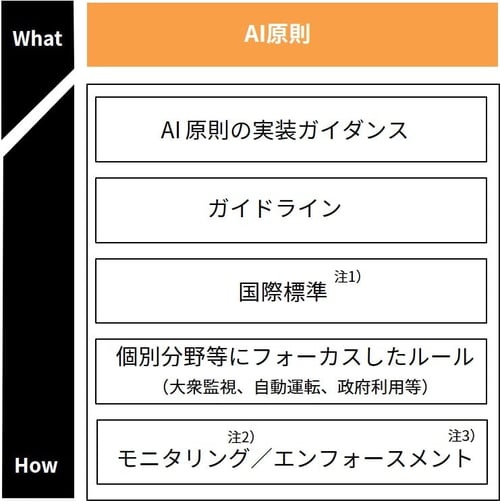

「信頼できるAI」を実現するための公的文書の種類は、2つに大別することができます。一つは「AI 原則」、もう一つは、それらの原則をシステムやサービスに実装するための方針や方策(例:「AI 原則の実装ガイダンス」、「ガイドライン」等)です。(図2参照)

図2 「信頼できるAI」の性質を定めた公的文書の種類(例)

出所)「我が国のAIガバナンスの在り方Ver1.1 」経済産業省を参考に作成

注1)国際標準:国際的に共通して使用される規格(標準)。国際電気通信連合(ITU)や国際標準

化機構(ISO)、国際電気標準会議(IEC )などの国際標準化機関が作成する標準(デジュール標準と呼ばれる)、IETF(Internet Engineering Task Force)やIEEE(The Institute of Electrical and Electronics Engineers, Inc)、W3C(World Wide Web Consortium)などの民間団体が作成する標準(デファクト標準)がある。

資料:総務省 情報通信技術の標準化ホームページ

https://www.soumu.go.jp/main_sosiki/joho_tsusin/hyojun/index.html#b02

注2)モニタリング:企業、人の行動や、AI(関連システムや機器等含む)の動作を観察・監視して、AI原則との乖離がないか等の評価に必要な情報収集を行うプロセスのこと。

注3)エンフォースメント:モニタリングを通じて、 AI原則からの逸脱など、何らかの問題が発見された場合に、当該問題の解消のため、ステークホルダー(AI開発者、AIを利用したサービス提供者、利用者、行政等)が取り得る行動のこと。

資料: 経済産業省「GOVERNANCE INNOVATION Society5.0の実現に向けた 法とアーキテクチャのリ・デザイン」https://www.meti.go.jp/press/2020/07/20200713001/20200713001-1.pdf

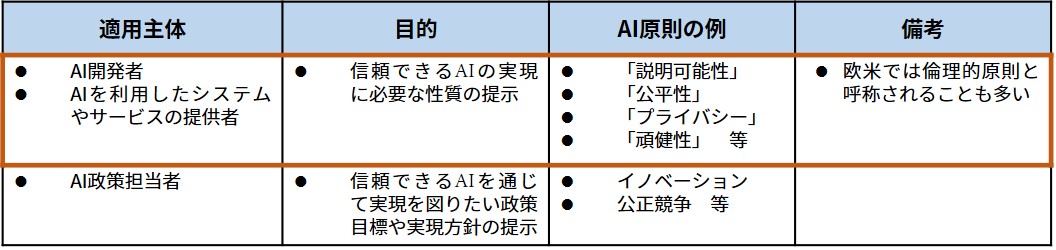

AI 原則は、その適用主体によって2種類に分けることができます。AI 開発者や AI を利用してシステムやサービスの提供者向けの AI 原則と、AI 政策担当者向けの AI 原則です。「信頼できる AI」を実現するための性質を定めているのは前者で、後者は、「信頼できる AI」を通じて実現を図りたい政策目標や実現方針を提示していると捉えることができます。(表1参照)

海外では両者を混同しないよう、前者を倫理的原則という名称(例:Ethical Principles等)で名づける公的文書も多くみられます。このような名称がつけられているのは、「信頼できる AI」を実現するためには、倫理的価値観や法的規範を遵守し、社会的利益に貢献する性質を持たせることが不可欠であることを反映したものと考えられます。

本記事では、AI 開発者や AI を利用してサービスを提供する主体向けの AI 原則に焦点をあてています。また、倫理的原則という用語ではなく、AI 原則という用語を使用します。

表1 AI原則の概要と本記事で捉えるAI原則の範囲

※オレンジ色太線枠が本記事で捉えるAI原則の範囲

出所)「我が国のAIガバナンスの在り方Ver1.1 」経済産業省を参考に作成

世界各国の公的文書にみるAI原則

世界各国や機関で公的文書の整備が進んだ結果、AI開発者やAIを利用してサービスを提供する主体向けのAI 原則(「信頼できる AI」に必要な性質)については、おおむねの国際的なコンセンサスがつくられつつあるといわれています。しかし、今のところ、AI 原則の標準が確立されているわけではありません。また、用語や定義が統一されていないのが実情です。

グローバル市場を意識して AI を利用したサービス提供を行うことを考える企業からみると、あちこちの公的文書の用語の意味解釈を行う手間が増えることは厄介です。公的文書をしっかりと参照すればするほど混乱し、AI 原則が実務で活用されず、AI 原則の形骸化が進む可能性もあります。

こうした状況を踏まえ、近年、AI やAI 倫理の専門家の間で、世界各国の公的文書で規定されているAI 原則に共通する性質を抽出し、用語の整理・体系化を試みる調査研究が進められています。

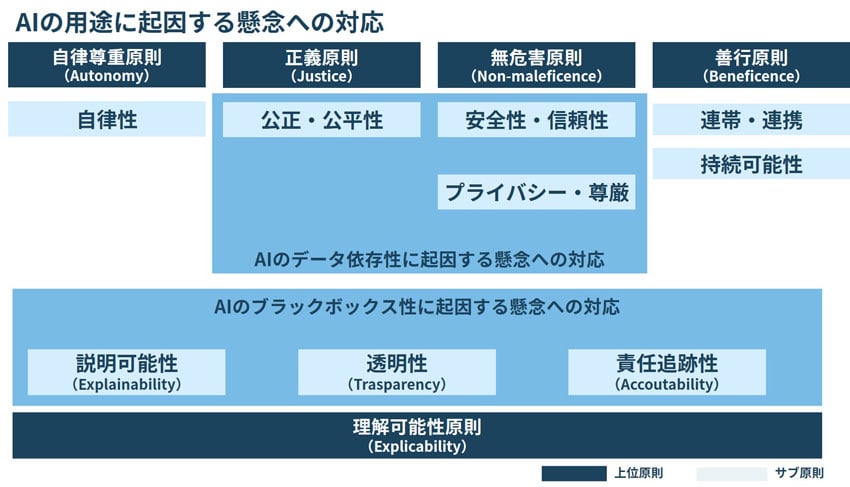

本記事では、そうした調査研究の成果(参照した主な論文・レポートについては本記事末尾に掲載)を活用し、実用性を考慮して整理したAI原則を紹介します。(図3参照)

図3 「信頼できるAI」が備えるべきAI原則の整理例

(AI開発者やAIを利用してサービスを提供する主体向け)

「信頼できるAI」が備えるべきAI原則は、AIの一般的な用途や特性を踏まえ5つの上位原則と9つのサブ原則から構成されるものとしています。

5つの上位原則は「自律尊重原則(Autonomy)」、「正義原則(Justice)」、「無危害原則(Non-maleficence)」、「善行原則(Beneficence)」「理解可能性(Explicability)」です。

9つのサブ原則はAI実際の用途や特性を踏まえて考慮する必要のある性質で、上位5つの原則と階層的にひもづけることで、各々の性質の意味付けと関連付けをしやすくし、理解を助けるようにしています。以下、これらのAI原則について解説します。

「自律尊重原則(Autonomy)」

自分の意思で決定することのできる人は、選択する自由をもち、自身のことを自分で決め、行動できるようにすべきであるという原則です。ここではサブ原則を1つだけとりあげます。

自律性

人間が自らの意思と判断によって AI を制御できるようにすべきであるということです。 AIから提供される情報に過度に依存し、過信すると、主体的な判断を妨げられ、意思決定の選択肢を狭めてしまいます。

これを防ぐためには、例えば、 AI が人間に複数の選択肢を示して人が最終判断を行う機能の検討が推奨されます。

また、医療診断や自動運転など、 AI の用途によっては判断や意思決定を AI 任せにしてしまうことが非常に危険な場合があります。このような場合は、最終判断を人間が行う仕組みにすることや、 AI の異常を監視し人間が適宜、非常停止できるようにする機能の検討が推奨されます。

AI 技術開発が進展する中、「どこまで AI に任せられるのか?」は常に議論の的となっています。現時点では、 AI に全てを任せきる(AI自身の自律性を認める)のではなく、人間が AI を制御することを原則とすべきというのが大方の論調です。

「善行原則(Beneficence)」

社会のために最善を尽くすべきであるという原則で、サブ原則は以下のとおりです。

連帯・連携

AI の有益性の増進とリスクの抑制に向けて、自らの開発する AI サービスと他の AI サービスとの相互接続性と相互運用性に配慮することが推奨されます。例えば、ステークホルダ(開発者、サービス提供者、利用者、各国政府、国際機関など)間で、同じ技術標準、ガイドライン、ベストプラクティスなどの遵守や適用をすることや、AIに関するサイバーセキュリティ攻撃情報、インシデント情報、トラブル事例等の共有に努めることが考えられます。

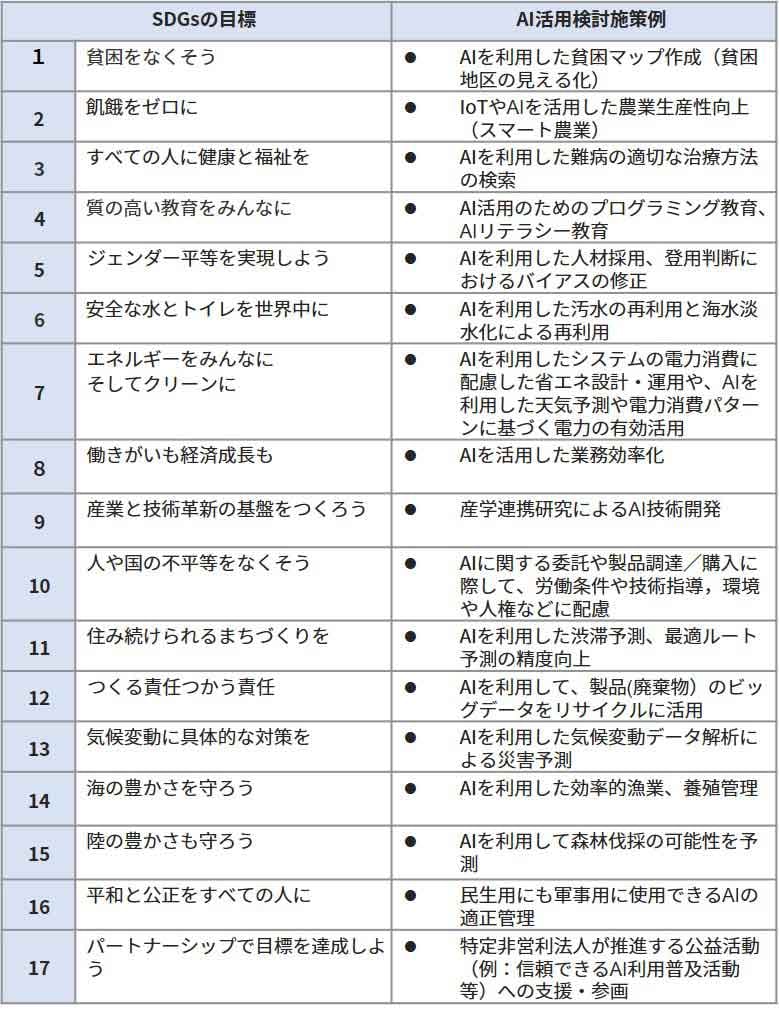

持続可能性

グローバルな社会経済活動の持続可能性確保の観点から AI を役立てていくことが望ましいという原則です。例えば、SDGs目標達成に貢献する施策の検討が推奨されます。

(表2参照)

表2 SDGsの目標とAI活用検討施策例

出所)「人工知能(AI)ビジネスのリスク、共存できる社会へ 持続可能な社会を実現するためのリスクマネジメント」を参考に作成 https://www.arm.or.jp/pdf/resource/ronbun/2018/063_071RMi.pdf

注)SDGs:Sustainable Development Goals(持続可能な開発目標)。

https://www.mofa.go.jp/mofaj/gaiko/oda/sdgs/about/index.html

「正義原則(Justice)」

人を平等かつ公平に扱うべきであるという原則です。限られた資源を公正に配分すべきであるという観点もこの原則に含まれています。サブ原則は以下のとおりです。

公正・公平性

特定の属性(例:性別、年齢、出身等)を持つ利用者グループに対して、差別的な判断を行わないようにすることをいいます。例えば、過去、女性採用に消極的だった企業が、それまでの採用実績データを基にして作成した AI を利用する場合、女性に対して極端にネガティブな評価を行うケースが挙げられます。多様な立場や観点で AI の検証を行う仕組みを構築し運用することが推奨されます。

「無危害原則(Non-maleficence)」

人や社会に危険や危害を及ぼさないようにすべきであるという原則です。今ある危険や危害を取り除き、予防することも含まれています。サブ原則は以下のとおりです。

安全性・信頼性

ノイズや異常のあるデータを読み込んでしまうと、動作異常を起こし、制御困難な状況に陥って安全確保に支障を来す可能性があります。

このため、ノイズ、異常データに過敏に反応しない頑健なアルゴリズムの検討が必要です。

また、悪意のあるデータを読み込んでしまうと、セキュリティ侵害や関係者への被害が生じる可能性があります。虚偽情報や真偽不明な情報を含むデータを取り込んでしまうと、誤った情報によって大きな混乱が発生する恐れもあります。

このため、そうしたリスクがないかどうか十分に検討し、セキュリティ対策強化を図ることが必要です。

近年のAIは統計的な処理を基礎としており、原理的に100%の精度保証はできません※2。問題が発生した場合の影響が深刻な場合(例:医療診断等)は、異常監視体制や非常停止体制の整備を検討することが推奨されます。

プライバシー・尊厳

例えば、健康管理データ、会員データ、防犯カメラデータなど一それぞれが匿名化されたデータであっても、個人と紐づいた大量のデータと組み合わせて利用すると、個人を特定できる可能性があるといわれています。本人の予期しない個人情報の取り扱いとみなされる可能性があり、プライバシー侵害や個人情報保護法違反となる可能性があるため、そうしたリスクがないかを十分に検討することが必要です。

また、ある特定の属性を持った利用者グループに対して何等かのネガティブな特性を抽出し、関連づけることで、本人の実像とは異なる不当なレッテルを当該利用者グループに属する個人に貼ってしまう恐れもあります。本人の尊厳にもかかわる可能性があるため、そうしたリスクがないかどうか十分に検討することが推奨されます。

ここで述べた「公正・公平性」および、「安全性・信頼性」、「プライバシー・尊厳」の各サブ原則は、AIの用途のみならず帰納的な方法によるデータ処理を強みとする近年の AI に潜むリスク※2に注目した原則といえます。

- ※2 帰納的な方法によるデータ処理を強みとする近年の AI に潜むリスク

近年の AI では、大きく分けるとルールベースと呼ばれる「演繹的」なアルゴリズムと、深層学習に代表される機械学習と呼ばれる「帰納的」なアルゴリズムが利用されており、後者が最近のAIの主流となっています。

機械学習は、音声、画像や言語を含む大量のデータを統計的に処理し、仮説検証を繰り返すことで、データに潜む法則性・規則性(パターン)を「帰納的」に見出すことが特徴です。「データ依存性」が非常に高いアルゴリズムで、大量のデータを利用して人間が説明できないような法則性・規則性(パターン)を見出せることが強みですが、その確からしさは、採用するデータや、その品質(欠損、誤り、外れ値等の程度 )に左右されます。

また、入力されたデータの意味内容を人間のように理解してデータ処理しているわけではありませんので、人間からみれば、差別的内容を含んだデータ、ノイズや異常のあるデータ、悪意のあるデータ、虚偽情報や真偽不明な情報を含むデータ、プライバシーや個人の尊厳を侵害する可能性のあるデータをAI 自身が人間と同じように見極めることはできません。

このため、「公正・公平性」および、「安全性・信頼性」、「プライバシー・尊厳」が損なわれる恐れがあるのです。

「理解可能性原則(Explicability)」

AIが社会に与える良い影響、悪い影響を理解出来るようにすべきという原則です。他の4原則、すなわち、「自律尊重原則(Autonomy)」、「正義原則(Justice)」、「無危害原則(Non-maleficence)」、「善行原則(Beneficence)」のいずれかが損なわれた場合に備えるという目的も含まれます。

動作保証が重視されるシステムや、事故が発生した場合の原因解明や責任判断が重要なシステムにおいて AI を利用する場合は、特に重視される原則で、サブ原則は以下のとおりです。

透明性

透明性とは、例えば、 AI を利用していることやどのように利用しているかをユーザに伝達することです。

説明可能性

説明可能性とは、AI 動作や処理結果に疑義が発生した場合の根拠(例:「どのようなパターンや規則性を見出してそのような結果が得られたのか」等)をできるだけ分かりやすく説明できるようにすることです。

責任追跡性

責任追跡性は、AI が導く結果に疑義が発生した場合の責任(法的責任含む)主体や報告・連絡・対処体制を明確にしておくことです。

上述したとおり、昨今の AI のモデルは、大量のデータを使って学習させるため、ヒトがそのロジックを完全に把握してコントロールすることも、その挙動を説明することも極めて困難という問題点があります。このような特徴は「ブラックボックス性」と言われることもあります。ここで述べた「Explicability(理解可能性原則)」は、こうした AI の特性に注目した AI 原則です。

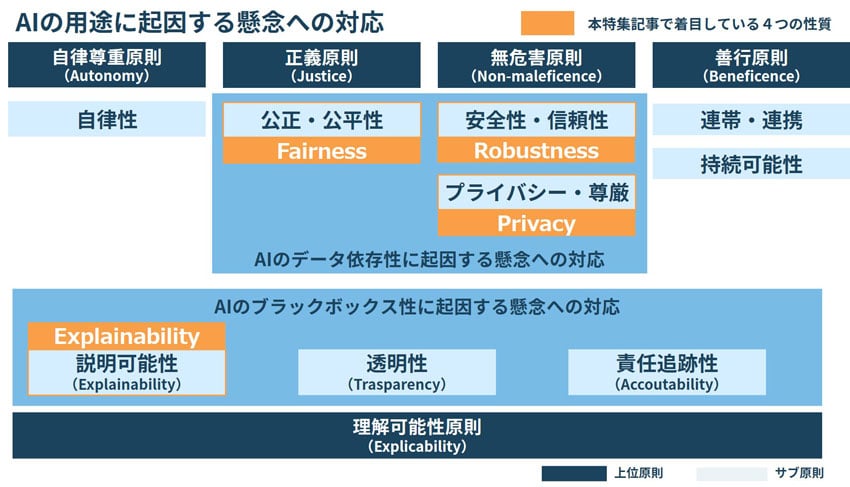

AI 原則と本特集で注目する4つの性質との関連

本特集で主に注目している4つの性質「Robustness(頑健性)」は「無危害原則」のサブ原則の「安全性・信頼性」に、「Explainability(説明可能性)」は「理解可能性原則」のサブ原則の「説明可能性」に、「Fairness(公平性)」は「正義原則」のサブ原則の「公正・公平性」に、「Privacy(プライバシー)」は、「無危害原則」のサブ原則の「プライバシー・尊厳」にそれぞれに紐づけることができます。(下図参照)

冒頭で、「モデルそのものが満たすべき性質」と述べたとおり、これら4つの性質は、帰納的な方法によるデータ処理を強みとする近年の AI の特性である「データの依存性」や「ブラックボックス性」に起因するリスクに注目したものと考えることができます。

一方で、4性質が紐づいていない「自律性原則」と「善行原則」は、主として「AI の用途」(「どこまで任せるか」、「どう使いこなすのか」)に注目した原則と考えることができます。

なお、「透明性」「責任追跡性」は、「Explainability(説明可能性)」とともに「理解可能性原則」に紐づくサブ原則ですが、モデルそのものに持たせる性質というよりは、「AI を利用していること」や、「どのように利用しているか」をユーザにいかに伝えるか、「問題が発生した際の責任の主体やレポートラインをどうするか」等、AI を利用したサービスをどのような方針や体制で提供するかに注目した性質と考えることができます。

Trustworthy AI(信頼できるAI)の実現に向けて

本記事で紹介したAI 原則は、AI を利用したシステム開発やサービス提供の際の懸念を明確化し、リスクや要件を確認する規準として役立てることができます。

自社の理念・ポリシー、施策や、自社のAI用途や特性を反映したAI原則を作成したい場合、特定の公的文書に記載されたAI 原則を取り込みたい場合は、サブ原則の AI 原則を追加、入れ替える、細分化するなど、適宜、カスタマイズするといったアプローチも考えられるでしょう。

今後、AI 原則を具現化するための公的文書(例:「AI原則の実装ガイダンス」、「ガイドライン」、等)の整備や、「規制」に関する検討が各国で進むと考えられます。

NRIセキュアの R&D チームは、そうした公的文書の整備動向や規制の検討動向を追いかけ、Trustworthy AI を実現するための知見の蓄積を進めていきます。

<主な参照論文・レポート>

- Floridi, Luciano; Cowls, Josh (2 July 2019). "A Unified Framework of Five Principles for AI in Society". Harvard Data Science Review. 1. doi:10.1162/99608f92.8cd550d1.

- Jobin, Anna; Ienca, Marcello; Vayena, Effy (2 September 2020). "The global landscape of AI ethics guidelines". Nature. 1 (9): 389–399.arXiv:1906.11668. doi:10.1038/s42256-019-0088-2. S2CID 201827642

- AI Ethics Guidelines: European and Global Perspectives 15 June 2020

AD HOC COMMITTEE ON ARTIFICIAL INTELLIGENCE (CAHAI) Provisional report by Marcello Ienca and Effy Vayena Chair of Bioethics, Health Ethics and Policy Lab, Department of Health Sciences and Technology, ETH Zurich.

https://rm.coe.int/cahai-2020-07-fin-en-report-ienca-vayena/16809eccac