NRIセキュアテクノロジーズ株式会社(本社:東京都千代田区、代表取締役社長:建脇 俊一、以下「NRIセキュア」)は、「AIセキュリティ統制支援サービス」[i]のラインナップの一つとして、生成AIを活用したシステムを対象にセキュリティ監視を行う「AI Blue Team(以下「本サービス」)」の提供を、本日開始します。

2023年12月にリリースしたセキュリティ診断サービス「AI Red Team」[ii]で、システム固有の脆弱性を洗い出したうえで本サービスを利用することで、大規模言語モデル(LLM)[iii]を活用したシステムのセキュリティ対策を包括的かつ継続的に実施することができます。

生成AI導入におけるリスク

生成AI、特にLLMを情報システムに組み込んで業務効率化や新規サービスに活用する動きが急速に広がる中で、それらについてのセキュリティ対策がますます重要になっています。LLMは、「プロンプトインジェクション」[iv]「プロンプトリーキング」[v]等の攻撃の標的となりうる脆弱性のほか、「ハルシネーション」[vi]「不適切なコンテンツの生成」「バイアスリスク」[vii]等の生成内容の信ぴょう性の観点や、予期せぬ「機微情報の漏洩」といったインシデント等、多岐にわたるセキュリティリスクをはらんでいます。

本サービスの概要と特長

NRIセキュアは、生成AI(LLM)を取り巻くこれらのリスクを的確に検知することに加え、新種の攻撃手法やシステムの運用開始後に検出された脆弱性に対処するため、関連情報を「インテリジェンス(セキュリティ脅威について収集・分析した情報等の総称)」として継続的に蓄積し、監視業務に適用していくことを重視しています。このたび、LLMに関連するリスクから導入企業のシステムを保護する仕組みを独自に開発し、アプリケーションとして本サービスに組み込みました(特許出願中)。

本サービスの目的は、企業がLLMの活用による業務効率化やビジネスの変革に注力できるよう、継続的な監視を通じてLLMに関連するリスク管理を支援することです。

なお、本サービスの導入にあたって、はじめにAI Red Teamによるセキュリティ診断を実施します。AI Red Teamの診断結果を元に、システム固有の問題に対するインテリジェンスを本サービスのアプリケーションに適用することで、一般的なAI防御ソリューションでは対処することが難しいリスクにも対策を施すことができます。

本サービスの主な特長は、以下の2点です。

1.生成AI活用システムを継続的にモニタリングし、広範囲かつ最新のAIリスクを回避

監視対象となるシステムと生成AI間で行われる入出力の情報を、本サービスで提供する「検知API」[viii]に連携し、有害な入出力を検知した場合、導入企業の担当者に通知します。前述したLLMが抱えるセキュリティリスクのモニタリングと対応に留まらず、NRIセキュアのアナリストが検知結果をもとに攻撃傾向を分析し、新種の攻撃手法等にも対応できるようにインテリジェンスを蓄積し、継続的に最新化します。アナリストがモニタリングする監視用画面は、導入企業の担当者もアクセスできるため、検知状況を直接確認することも可能です。

2.AI Red Teamで検出したシステム固有の脆弱性を防御し保護レベルを強化

生成AIを活用したシステムの開発現場では、どのようなケースでAIを活用しているか等のAIへの依存方式や権限委譲レベルに応じて、システム固有の脆弱性が作り込まれてしまうことがあります。このような脆弱性は汎用的な防御ソリューションでは対処できず、個別の対策が求められます。

本サービスでは、AI Red Teamのセキュリティ診断で検出されたシステム固有の脆弱性にも対応できるよう、汎用的なインテリジェンスとは別に導入企業専用のインテリジェンスを蓄積します。これにより、固有の脆弱性を攻撃から防御しつつ、システム全体の保護レベルを一層強化することが期待できます。

図:AI Blue TeamとAI Red Teamを併用した生成AI活用システムのセキュリティ強化策

本サービスの詳細については、次のWebサイトをご参照ください。

https://www.nri-secure.co.jp/service/assessment/ai-blue-team

NRIセキュアは今後も、企業・組織の情報セキュリティ対策を支援するさまざまな製品・サービスを提供し、安全・安心な情報システム環境と社会の実現に貢献していきます。

[i] AIセキュリティ統制支援サービス:詳細については「ご参考」を参照ください。

[ii] AI Red Team:新たに生成AIを利用するシステムやサービスを対象にした、セキュリティ診断サービスです。詳細は次のWebサイトをご参照ください。https://www.nri-secure.co.jp/service/assessment/ai-red-team

[iii] 大規模言語モデル(LLM):LLMは、Large Language Modelの略で、大量のテキストデータを利用してトレーニングされた自然言語処理モデルのことです。

[iv] プロンプトインジェクション:主に、攻撃者が入力プロンプトを操作して、モデルから予期しない、または不適切な情報を取得する試みを指します。

[v] プロンプトリーキング:攻撃者が入力プロンプトを操作して、もともとLLMに設定されていた指令や機密情報を盗み出そうとする試みを指します。

[vi] ハルシネーション:AIが事実に基づかない情報を生成する現象を指します。

[vii] バイアスリスク:トレーニングデータの偏りやアルゴリズム設計により、偏った判断や予測を引き起こす現象を指します。

[viii] API:Application Programming Interfaceの略称で、プログラムの特定の機能をその他のプログラムでも利用できるようにする技術です。

ご参考

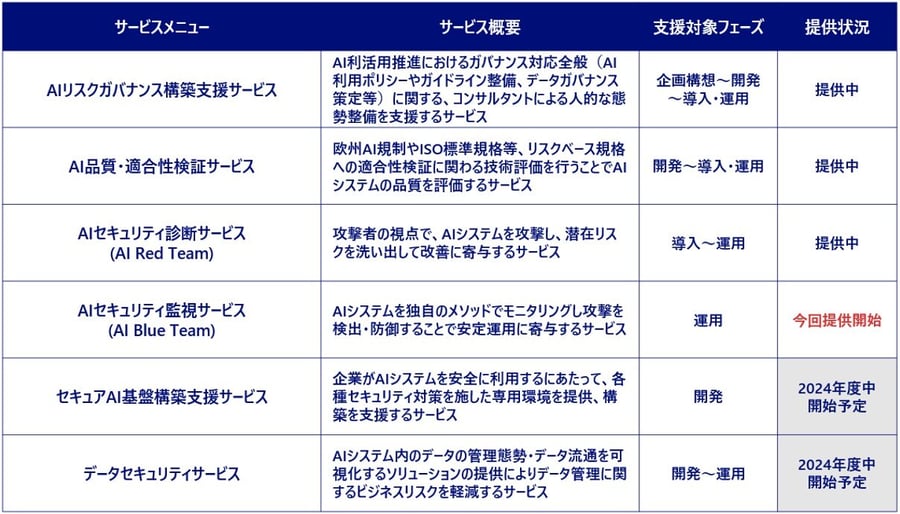

NRIセキュアが提供するAIセキュリティ統制支援サービスについては、次のWebサイトおよび一覧表をご参照ください。https://www.nri-secure.co.jp/service/ai-security

「AIセキュリティ統制支援サービス」のメニュー一覧

ニュースに関するお問い合わせ

NRIセキュアテクノロジーズ株式会社 広報担当

E-mail:info@nri-secure.co.jp